“o4-mini”に匹敵!?|OpenAIのOSSモデル”gpt-oss”を試す

2025年8月5日にOpenAIからオープンウェイトのAIモデル”gpt-oss”が発表されました。同日、LM Studioも0.3.22にアップグレードされ、gpt-ossに対応したため、早速使ってみました。

gpt-ossとは

“gpt-oss”は、OpenAIが発表したオープンウェイトの大規模言語モデルです[公式リリース]。

モデルは、1,170億パラメータのgpt-oss-120bと、210億パラメータのgpt-oss-20bがあります。これらはダウンロードすればローカルで動作させることができ、gpt-oss-20bは16GBのメモリで動作するとされています。

MacBook Air(M2, 16GB)では、そのままではダウンロード画面に「モデルが大きすぎる」警告が出ました。Macの場合、24GBか32GBくらいはメモリが必要そうです。

また、同日LM Studioもgpt-ossをサポートしたバージョン(0.3.22)の提供を開始しました。

gpt-oss-120bのサイズが63.39 GB、gpt-oss-20bのサイズが12.11 GBということで、どちらのモデルも手持ちのMacBook Pro(M4 Max 128GB)で動作しそうだったので、早速試してみました。

モデルも手持ちのMacBook Pro(M4 Max 128GB)で動作するようなので早速試してみました。

コンテストでは、生成AIの使用は禁止されていますので注意してください(AtCoder生成AI対策ルール – 20250718版)

私は、過去問を解く時に生成AIと同時に解いて競争しています(笑)

モデルの概要

公式ページによると、gpt-oss-120bとgpt-oss-20bのモデルサイズ等は以下の通りです。

MoE(Mixture-Of-Experts)モデルで、一度にアクティブになるパラメータ数がそれぞれ51億、36億と小さいのが特徴で、高速な動作が期待できます。エキスパートが128、32と多いのもポイントかもしれません。

| モデル | レイヤー | パラメータ合計 | トークンあたりのアクティブパラメータ数 | エキスパート合計 | トークンあたりのアクティブエキスパート数 | コンテキスト長 |

| gpt-oss-120b | 36 | 117b | 5.1b | 128 | 4 | 128k |

| gpt-oss-20b | 24 | 21b | 3.6b | 32 | 4 | 128k |

LM Studioでダウンロードしたモデルをみると、以下のような表示になります。MXFP4というのも独自の量子化手法のようです。モデルもgpt-ossと独自です。

気になる速度は?

チャット品質や性能に関してはYouTubeなどで様々な動画が出ているため、この記事では、MacBook Proでの動作速度について、実際に動かした結果を報告したいと思います。

MacBook Proのスペック

手持ちのMacBook Proは、M4MAX, 128GBのモデルになります。一応、MacBook Proとしては最大までメモリを搭載しているモデルです。

PCスペック: MacBook Pro(M4MAX 128GB)

モデル設定:

- コンテキストサイズ128K

- Reasoning EffortはLow, Mid, Highの3設定

Reasoning Effortは、推論の深さを設定するパラメータです。Highにすると長考するようになります。

gpt-oss-20b

ロードすると12GB弱のメモリを使います。16GBのモデルでもギリギリ実行できるレベルかもしれません。

| Reasoning Effort設定 | tok/秒 | First Token |

| Low | 81.40 tok/sec | 0.68s |

| Medium | 78.30 tok/sec | 0.67s |

| High | 77.35 tok/sec | 0.69s |

| Qwen3-30B-A3B(参考) | 83.25 tok/sec | 0.07s |

80tok/秒は、このサイズのモデルの中ではかなり高速です。Qwen3-30B-A3Bと同等の印象を受けました。メモリ使用量も少ないため、LM Studioを常時起動しておいて、使いたい時にすぐに使うといった使い方が可能だと感じました。

応答速度も高速なので、ローカルLLMとしては使いやすいと感じます。

会話を続けたり、プロンプトとして与えるテキストの量が多くなると速度は低下します。私が使った範囲では、50tok/秒程度は維持している印象でした。

なお、いくつかのAtCoderの問題を解かせてみましたが、実力的にはQwen3-30B-A3Bと同程度だと感じます。ABC問題の難しめの問題に関しては、惜しいところまでいくものの、あと一歩及ばない回答を出力する傾向がありました。

gpt-oss-120b

ロードすると約80GBのメモリを使用します。他のアプリケーションも実行している私の環境では、ロードすると10GB程度しかメモリが残りませんでした。

| Reasoning Effort設定 | tok/秒 | First Token |

| Low | 52.00 tok/sec | 0.40s |

| Midium | 53.75 tok/sec | 1.97s |

| High | 49.59 tok/sec | 1.84s |

| llama-4-scout-17b-16e | 41.65 tok/sec | 3.34s |

| glm-4.5-air(参考) | 49.81 tok/sec | 0.99s |

100Bを超えるモデルで50tok/秒は非常に高速です。この速度なら普段使いも十分に可能だと感じました。ただし、コンテキストを最大にするとメモリがギリギリになるため、128GBモデルでは常時起動しておくといった使い方は難しいかもしれません。

llama-4-scout-17b-16eは109B、glm-4.5-airは106Bと同程度のサイズのMoEモデルなので参考として速度計測しています。

AtCoderのABC問題を解かせたところ、20bでは解けなかった問題が解けるなど、明らかに性能の高さが確認できました。しかし、通常のプログラミング用途では、20bでも十分だと感じました。

最近はプログラミングにQwen3-30B-A3Bを使っていますが、gpt-oss-20bでも代替可能だと感じます。120bを使えると理想的ですが、メモリを圧迫するのが課題です。

競プロ問題に関して

具体例として、AtCoder ABC417-E問題をQwen3-30B-A3B、gpt-oss-20b、gpt-oss-120bで解かせてみたところ、以下の結果が得られました。

- Qwen3-30B-A3B:方針は合っていましたが、コードの実装にミスがありました。

- gpt-oss-20b:TLE(実行時間制限超過)するコードを提示し、何度か質問しても改善されませんでした。

- gpt-oss-120b:一発で正解のコードを出力できました。

この結果から、gpt-oss-120bは大きなモデルだけあって、他の2つと比べると頭一つ抜けた実力を持っていると言えるでしょう。

Qwen3の出力でも考え方のヒントとして十分(あとは自力で解ける)な出力をしてくれます。

過去問を解く時に行き詰まったら解法を調べたりする程度

その他:ツール呼び出し

ツール呼び出しに対応していますが、自作のMCPサーバーの呼び出しに一度失敗しました。会話をクリアしてやり直したら成功しましたが、安定性に欠ける印象です。この点は他のモデルでも同様の傾向が見られます。

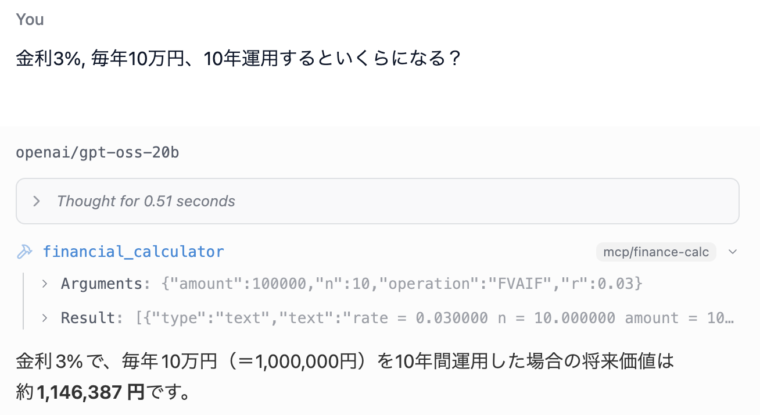

以下、gpt-oss-20bで自作のfinancial_calculatorを呼び出したチャットの例です。

上記のように、途中でfinancial_calculatorを呼び出して計算を行っています。

追記(2025/8/12)

Webフェッチと、Google Search用のMCPサーバーを導入してみたところ、必要があればGoogle検索して情報を取得・回答するというのが普通にできました。明示的に指定しない場合は、検索は動かないこともありますが、それはChatGPTなどのクラウドサービスでも同じ。

とりあえず、ローカルLLMで「最新情報を検索して答える」ができるようになりました。

ツール呼び出しは、20B, 30Bといったそれなりに大きなモデルしか安定しない印象です。gpt-oss-20bは、他のモデルと比較してもツール呼び出しを安定して行ってくれる印象です。

追記(2025/08/16)

HP OmniBook 7 Aero 13-bgでベンチマーク

HP OmniBook 7 Aero 13-bg1010AUでもgpt-oss-20bなら動きそうだったので動かしてみました。

PCスペック

- AMD Ryzen™ AI 7 350

- メモリ32GB

結果

Reasoning Effort設定を変更してもそれほど変わらなかったので、今回はGPU利用・CPU利用で比較してみました。意外なことにGPUを使わない方が高速でした(GPUを使用した場合に、GPUメモリの増加とGPUの使用は確認済み)。

| CPU/GPU | tok/秒 | First Token |

| CPU | 13.13 tok/sec | 7.50s |

| GPU | 6.39 tok/sec | 2.24s |

| MacBook Pro M4Max(参考) | 81.40 tok/sec | 0.68s |

現状ではgpt-oss-20bはCPUの方が高速みたいです。何度か実行しましたがCPU>GPUの傾向は変化しませんでした。

なお、コンテキストを増やしすぎるとエラーになります。32GBのメモリではコンテキストを最大にすることはできないようです。

まとめ

MacBook Pro(M4 Max, 128GB)で、gpt-ossを動作させてみました。120bのモデルでもかなり快適な速度で動作するため、実用的だと感じました。

| モデル | tok/秒 |

| gpt-oss-20b | 40〜80tok/sec |

| gpt-oss-120b | 20〜50 tok/sec |

128GBのメモリでは大規模なモデルには不足するため、QwenやDeepSeekの大型モデルは使えなかったのですが、128GBのメモリでも動作させることができる大きめのモデルとしては、現時点(2025年8月6日時点)ではgpt-ossが一択と言えるでしょう。

Command RやLlamaの70B、100Bクラスのモデルは応答に待たされることがありますが、それらに比べて高速なのは高評価ポイントです。

LLMの世界は目覚ましい勢いで進展しているので、来月や来年にはきっとさらに優れたモデルが登場すると思いますが、しばらくはQwen3かgpt-ossを使うことになりそうです。