【Python】日本語対応のワードクラウドを作成(単語分割の方法)

Pythonでワードクラウドを作成する場合、wordcloudライブラリを使うと手軽にビジュアル化することができますが、日本語テキストを扱う場合は独特の課題があります。それは、文章を単語に分割し、必要な要素だけを抜き出す作業です。本記事では、形態素解析にJanomeを利用し、日本語のワードクラウドを作成する手順をわかりやすく解説します。

ワードクラウドって何?

ワードクラウド(Word Cloud)は、単語の出現頻度に応じて大きさを変えて並べたものです。

一時期流行ったことがあるので知っている人も多いのではないでしょうか。

最近、ワードクラウドを作る機会があったので、Pythonでのワードクラウドの作り方を紹介したいと思います。

下の図は、このブログのトップページのワードクラウドです。YOLOという文字が一番多いみたいです。また、ブログはAI系の記事が多いので、機械学習関連の記事が並んでいます。

このように、頻度に合わせて文章をビジュアル化するのがワードクラウドです。

使い方は?

例えば、TeamsやSlackの記事から作ってプレゼンテーション資料や会議のネタとして利用することができます。例えば、アンケートの自由記述欄からワードクラウドを作成すれば、話題に上がったキーワードを可視化できます。

ワードクラウドは、プレゼンテーション資料でのテキストの可視化手段として有効に利用できます。

Pythonでの作り方

wordcloudライブラリを使えば、Pythonでワードクラウドを作るのは簡単です。以下、手順を説明します。

インストール

wordcloudライブラリをインストールします

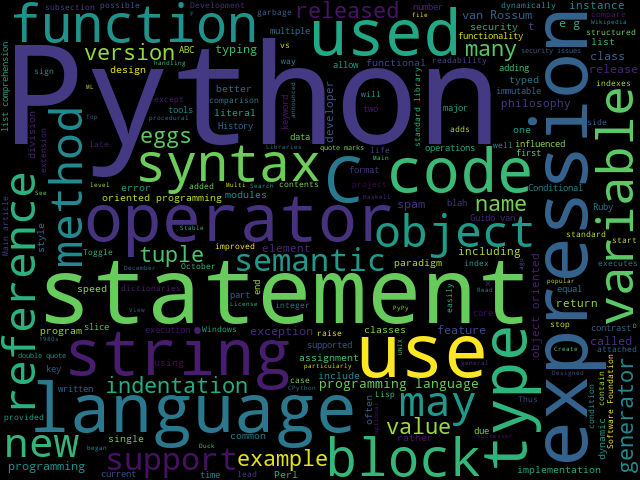

pip3 install wordcloud 英語の場合

英語の場合は、テキストを入力するだけで簡単にワードクラウドを作成することが可能です。

入力はなんでも良いですが、とりあえずsample.txtを読み込んでワードクラウドを作成してみます。ちなみに、サンプルでsample.txtは、英語版Wikipediaのpythonの項目です。自身で試す場合は、適当な文章をsample.txtとして作成してください。

from wordcloud import WordCloud

with open('sample.txt', 'r', encoding='UTF-8') as f :

text = f.read()

wc = WordCloud(width=640, height=480)

wc.generate(text)

wc.to_file('result.png')

日本語の場合

英語の場合は単語毎にスペースで区切られているので、前処理をしなくてもワードクラウドを作成することができました。日本語の場合は単語がスペースで区切られていないので、単語を抜き出す作業が必要です。この処理を行うのが形態素解析ライブラリになります。

形態素解析(Janome)

形態素解析ライブラリと言えばMeCabが人気ですが、ここではJanomeを利用します。

JanomeはMeCabと比べて、Pythonのパッケージ管理ツールpipだけでインストールできます。

ワードクラウドを作るだけなので、どちらでも良いと思いますが、手軽さでJanomeを選びました

pip install janomejanomeの使い方は以下のようになります。

tokenize()を実行すると、tokenが切り出されます。tokenには、切り出された単語(token.surface)と、品詞(token.part_of_speech)が格納されています。

from janome.tokenizer import Tokenizer

t = Tokenizer()

text = 'Janomeは人気の形態素解析ライブラリです'

for token in t.tokenize(text):

print(token.surface, "->", token.part_of_speech)

Janome -> 名詞,固有名詞,組織,*

は -> 助詞,係助詞,*,*

人気 -> 名詞,一般,*,*

の -> 助詞,連体化,*,*

形態素 -> 名詞,一般,*,*

解析 -> 名詞,サ変接続,*,*

ライブラリ -> 名詞,一般,*,*

です -> 助動詞,*,*,*名詞のみを抽出

ワードクラウドを作る場合、「は(助詞)」「の(助詞)」「です(助動詞)」などは入れたくありません。ここでは、名詞のみを取り出すようにしています。

以下のコードはsample-j.txtを読み込んで、品詞が名詞のものだけ取り出すコードです。8~9行目が名詞を取り出す部分です。品詞を,でsplitして、その中に名詞が含まれているかチェックしています。

with open('sample-j.txt', 'r', encoding='UTF-8') as f :

text = f.read()

t = Tokenizer()

s = []

for token in t.tokenize(text):

p = token.part_of_speech.split(",")

if "名詞" in p:

s.append(token.surface)ワードクラウドを作成

以下がsample-j.txtを読み込んでワードクラウドを作成するコードになります。

なお、" ".join(s)は、名詞を連結する処理になります。

from janome.tokenizer import Tokenizer

from wordcloud import WordCloud

with open('sample-j.txt', 'r', encoding='UTF-8') as f :

text = f.read()

t = Tokenizer()

s = []

for token in t.tokenize(text):

p = token.part_of_speech.split(",")

if "名詞" in p:

s.append(token.surface)

wc = WordCloud(width=640, height=480,

font_path="/System/Library/Fonts/Arial Unicode.ttf")

wc.generate(" ".join(s))

wc.to_file('result-j.png')

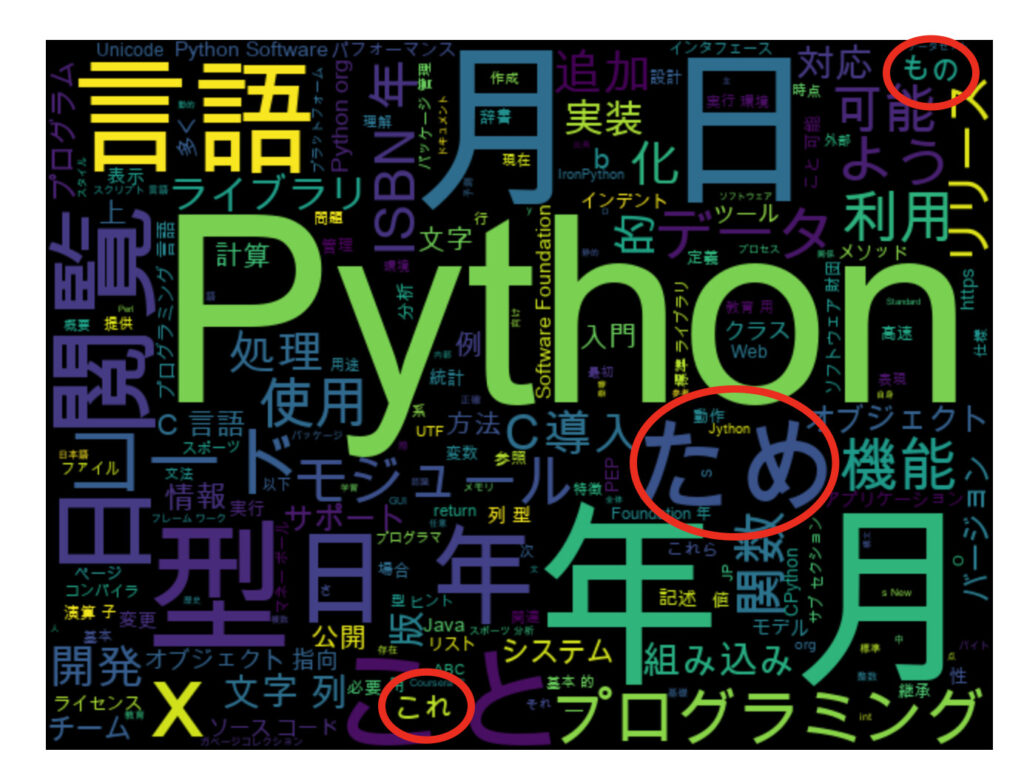

今回のサンプルに利用したテキストは、日本語WikipediaのPythonの項目です。

実行すると以下のようなワードクラウドができますが、赤丸で囲んだ「もの」「ため」「これ」などは除外したいです。

ワードクラウドからこれらのワードを除外するには、引数stopwordsに除外したいキーワードを列挙しておきます。とりあえず、上記の3つ+いくつかのワードを除外する対象に入れておきます。コードは以下のようになります。

from janome.tokenizer import Tokenizer

from wordcloud import WordCloud

with open('sample-j.txt', 'r', encoding='UTF-8') as f :

text = f.read()

t = Tokenizer()

s = []

for token in t.tokenize(text):

p = token.part_of_speech.split(",")

if "名詞" in p:

s.append(token.surface)

wc = WordCloud(width=640, height=480,

stopwords={"ため","こと","もの", "よう", "これ", "あれ"},

font_path="/System/Library/Fonts/Arial Unicode.ttf")

wc.generate(" ".join(s))

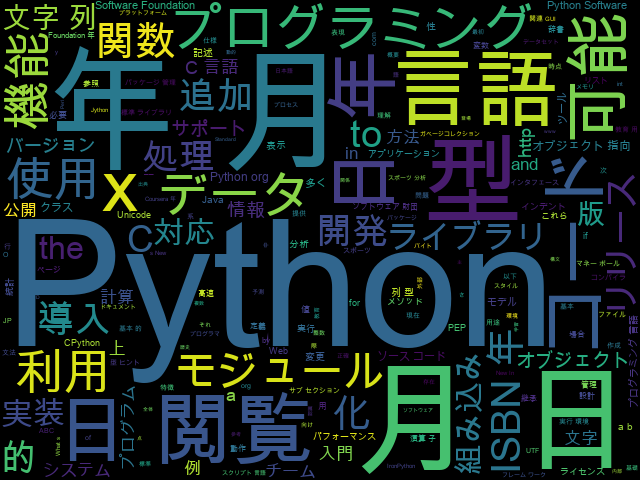

wc.to_file('result-j.png')このコードを実行した結果が以下になります

日本語フォントについて(Mac/Windows)

ここまでのコードはMacOSで実行することを想定していました。これは、font_pathが理由です。

Macは/System/Library/Fonts/にフォントが格納されていますが、Windowsの場合は、C:/Windows/Fonts/に格納されています。

また、フォント名も異なります。

とりあえず、フォント名を以下に変更すればWindowでも動作するはずです。

C:/Windows/Fonts/HGRSGU.TTC

手元にWindows環境がないので試してませんがおそらく動作すると思います。

IPAフォントを利用する

「フォントの問題があるなら、フォントを別途用意すれば良い」ということで、ここでは、IPAフォントを利用してワードクラウドを作成する方法を紹介します。

といっても、難しいことはなく、まずフォントを以下のリンクからダウンロードしてきます。

上記のリンクからダウンロードページに飛べばダウンロードできます。IPAexフォント Ver.001.03(ipaexg00102.zip)をダウンロードした場合で説明します。

ダウンロードしたzipファイルを展開すると、ipaexg.ttfというファイルがあるので、これを、.pyファイルのあるフォルダ(カレントディレクトリ)にコピーします。

その後、以下のpythonコードを実行すれば、ダウンロードしたIPAフォントを利用してワードクラウドを作ることができます。

この方法であれば、Windows/MacOS/Linux関係なく、ワードクラウドを作成することができます。

日本語フォントの問題は面倒なので、IPAフォントなどを使うのも1つの解決策です

from janome.tokenizer import Tokenizer

from wordcloud import WordCloud

with open('sample-j.txt', 'r', encoding='UTF-8') as f :

text = f.read()

t = Tokenizer()

s = []

for token in t.tokenize(text):

p = token.part_of_speech.split(",")

if "名詞" in p:

s.append(token.surface)

wc = WordCloud(width=640, height=480,

stopwords={"ため","こと","もの", "よう", "これ", "あれ"},

font_path="./ipaexg.ttf")

wc.generate(" ".join(s))

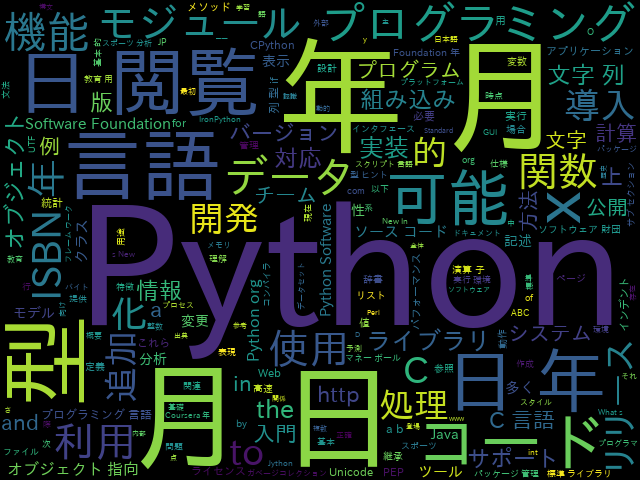

wc.to_file('result-j.png')IPAフォントを使ったので、フォントが若干違うことがわかります。

背景と文字色

WordCloud()に以下の引数を指定することで、背景色と文字色を変更できます。

background_color

background_color="white"または、background_color="black"を設定できます。

colormap

colormap="文字列"の形式で指定できます。

文字列には、以下が設定できます。

カラーマップのサンプルはこちらの記事にありました。

‘Accent’, ‘Accent_r’, ‘Blues’, ‘Blues_r’, ‘BrBG’, ‘BrBG_r’, ‘BuGn’, ‘BuGn_r’, ‘BuPu’, ‘BuPu_r’, ‘CMRmap’, ‘CMRmap_r’, ‘Dark2’, ‘Dark2_r’, ‘GnBu’, ‘GnBu_r’, ‘Greens’, ‘Greens_r’, ‘Greys’, ‘Greys_r’, ‘OrRd’, ‘OrRd_r’, ‘Oranges’, ‘Oranges_r’, ‘PRGn’, ‘PRGn_r’, ‘Paired’, ‘Paired_r’, ‘Pastel1’, ‘Pastel1_r’, ‘Pastel2’, ‘Pastel2_r’, ‘PiYG’, ‘PiYG_r’, ‘PuBu’, ‘PuBuGn’, ‘PuBuGn_r’, ‘PuBu_r’, ‘PuOr’, ‘PuOr_r’, ‘PuRd’, ‘PuRd_r’, ‘Purples’, ‘Purples_r’, ‘RdBu’, ‘RdBu_r’, ‘RdGy’, ‘RdGy_r’, ‘RdPu’, ‘RdPu_r’, ‘RdYlBu’, ‘RdYlBu_r’, ‘RdYlGn’, ‘RdYlGn_r’, ‘Reds’, ‘Reds_r’, ‘Set1’, ‘Set1_r’, ‘Set2’, ‘Set2_r’, ‘Set3’, ‘Set3_r’, ‘Spectral’, ‘Spectral_r’, ‘Wistia’, ‘Wistia_r’, ‘YlGn’, ‘YlGnBu’, ‘YlGnBu_r’, ‘YlGn_r’, ‘YlOrBr’, ‘YlOrBr_r’, ‘YlOrRd’, ‘YlOrRd_r’, ‘afmhot’, ‘afmhot_r’, ‘autumn’, ‘autumn_r’, ‘binary’, ‘binary_r’, ‘bone’, ‘bone_r’, ‘brg’, ‘brg_r’, ‘bwr’, ‘bwr_r’, ‘cividis’, ‘cividis_r’, ‘cool’, ‘cool_r’, ‘coolwarm’, ‘coolwarm_r’, ‘copper’, ‘copper_r’, ‘cubehelix’, ‘cubehelix_r’, ‘flag’, ‘flag_r’, ‘gist_earth’, ‘gist_earth_r’, ‘gist_gray’, ‘gist_gray_r’, ‘gist_heat’, ‘gist_heat_r’, ‘gist_ncar’, ‘gist_ncar_r’, ‘gist_rainbow’, ‘gist_rainbow_r’, ‘gist_stern’, ‘gist_stern_r’, ‘gist_yarg’, ‘gist_yarg_r’, ‘gnuplot’, ‘gnuplot2’, ‘gnuplot2_r’, ‘gnuplot_r’, ‘gray’, ‘gray_r’, ‘hot’, ‘hot_r’, ‘hsv’, ‘hsv_r’, ‘inferno’, ‘inferno_r’, ‘jet’, ‘jet_r’, ‘magma’, ‘magma_r’, ‘nipy_spectral’, ‘nipy_spectral_r’, ‘ocean’, ‘ocean_r’, ‘pink’, ‘pink_r’, ‘plasma’, ‘plasma_r’, ‘prism’, ‘prism_r’, ‘rainbow’, ‘rainbow_r’, ‘seismic’, ‘seismic_r’, ‘spring’, ‘spring_r’, ‘summer’, ‘summer_r’, ‘tab10’, ‘tab10_r’, ‘tab20’, ‘tab20_r’, ‘tab20b’, ‘tab20b_r’, ‘tab20c’, ‘tab20c_r’, ‘terrain’, ‘terrain_r’, ‘twilight’, ‘twilight_r’, ‘twilight_shifted’, ‘twilight_shifted_r’, ‘viridis’, ‘viridis_r’, ‘winter’, ‘winter_r’

まとめ

以上、Pythonでワードクラウドを作成する方法について説明しました。

ワードクラウド作成用のWebツールなどもいくつか存在していますが、テキストデータをアップロードしたくない場合などは、ローカルな環境で実行できるPythonのコードは役に立つと思います。